Esta página ou se(c)ção precisa ser formatada para o padrão wiki. |

A inteligência artificial (IA) é uma importante área de pesquisa da Ciência da Computação dedicada a buscar métodos ou dispositivos computacionais que possuam ou simulem a capacidade humana de resolver problemas, pensar ou, de forma ampla, ser inteligente.

O trabalho começou logo após a Segunda Guerra Mundial, e o próprio nome foi cunhado em 1956. Seus principais idealizadores foram os cientistas Marvin Minsky, Herbert Simon, Allen Newell, John McCarthy, Warren MuCulloch e Walter Pitts, entre outros.

A construção de máquinas inteligentes fascina a humanidade desde tempos imemoriais, havendo na história um registro significante de automatos mecânicos (reais) e personagens míticos, como Frankstein, que podem ser considerados representantes da busca de uma IA.

Apenas recentemente, com o surgimento do computador moderno, é que a inteligência artificial ganhou meios e massa crítica para se estabelecer como ciência integral, com problemáticas e metodologias próprias. Desde então, seu desenvolvimento tem extrapolado os clássicos programas de xadrez ou de conversão e envolvido áreas como visão computacional, análise e síntese da voz, lógica difusa, redes neurais artificiais e muitas outras.

Inicialmente a IA visava reproduzir o pensamento humano. A Inteligência Artificial abraçou a idéia de reproduzir faculdades humanas como criatividade, auto-aperfeiçoamento e uso da linguagem. Porém, o conceito de inteligência artificial é bastante difícil de se definir. Por essa razão, Inteligência Artificial foi (e continua sendo) uma noção que dispõe de múltiplas interpretações, não raro conflitantes ou circulares.

Visão geral

A questão sobre o que é inteligência artificial, mesmo como definida anteriormente, pode ser separada em duas partes: "qual a natureza do artificial" e "o que é inteligência". A primeira questão é de resolução relativamente fácil, apontando no entanto para a questão de o que poderá o homem construir.

A segunda questão é consideravelmente mais difícil, levantando a questão da consciência, identidade e mente (incluindo a mente inconsciente) juntamente com a questão de que componentes estão envolvidos no único tipo de inteligência que universalmente se aceita como estando ao alcance do nosso estudo: a inteligência do ser humano. O estudo de animais e de sistemas artificiais que não são modelos triviais, começam a ser considerados como matéria de estudo na área da inteligência.

IA forte e IA fraca

Entre os teóricos que estudam o que é possível fazer com a IA existe uma discussão onde se consideram duas propostas básicas: uma conhecida como "forte" e outra conhecida como "fraca". Basicamente, a hipótese da IA forte considera ser possível criar uma máquina consciente.

Uma popular e inicial definição de inteligência artificial, introduzida por John McCarty na famosa conferência de Dartmouth em 1955 é "fazer a máquina comportar-se de tal forma que seja chamada inteligente caso fosse este o comportamento de um ser humano." No entanto, esta definição parece ignorar a possibilidade de existir a IA forte (ver abaixo).

Outra definição de inteligência artificial é a inteligência que surge de um dispositivo artificial. A maior parte das definições podem ser categorizadas em sistemas que: pensam como um humano; agem como um humano; pensam racionalmente ou agem racionalmente.

Inteligência artificial forte

A investigação em Inteligência artificial forte aborda a criação da forma de inteligência baseada em computador que consiga raciocinar e resolver problemas; uma forma de IA forte é classificada como auto-consciente.

A IA forte é tema bastante controverso, pois envolve temas como consciência e fortes problemas éticos ligados ao que fazer com uma entidade que seja cognitivamente indiferenciável de seres humanos.

A Ficção Científica tratou de muitos problemas desse tipo. Isaac Asimov, por exemplo, escreveu O Homem Bicentenário, onde um rôbo consciente e inteligente luta para possuir um status semelhante a de um humano na sociedade. Por outro lado, o mesmo Asimov reduz os robôs a servos dos seres humanos ao propor as três leis da robótica.

Inteligência artificial fraca

Trata-se da noção de como lidar com problemas não determinísticos.

Uma contribuição prática de Alan Turing foi o que se chamou depois de Teste de Turing (TT), de 1950: em lugar de responder à pergunta "podem-se ter computadores inteligentes?" ele formulou seu teste, que se tornou praticamente o ponto de partida da pesquisa em "Inteligência Artificial".

O teste consiste em se fazer perguntas a uma pessoa e um computador escondidos. Um computador e seus programas passam no TT se, pelas respostas, for impossível a alguém distinguir qual interlocutor é a máquina e qual é a pessoa (interessante é que ele não especificou o nível intelectual e cultural do perguntador...).

No seu artigo original ele fez a previsão de que até 2000 os computadores passariam seu teste. Pois bem, há um concurso anual de programas para o TT, e o resultado dos sistemas ganhadores é tão fraco (o último tem o nome "Ella") que com poucas perguntas logo percebe-se a idiotice das respostas da máquina. É interessante notar que tanto a Máquina de Turing quanto o Teste de Turing talvez derivem da visão que Turing tinha de que o ser humano é uma máquina.

Há quem diga que essa visão está absolutamente errada, do ponto de vista linguístico, já que associamos à "máquina" um artefato inventado e eventualmente construído. Dizem eles: "Nenhum ser humano foi inventado ou construído". Afirma-se ainda que a comparação, feita por Turing, entre o homem e a máquina é sinônimo de sua "ingenuidade social", pois as máquinas são infinitamente mais simples do que o homem, apesar de, paradoxalmente, se afirmar que a vida é complexa. No entanto, esta linha de raciocínio é questionável, afinal de contas, os computadores modernos podem ser considerados "complexos" quando comparados ao COLOSSUS (computador cujo o desenvolvimento foi liderado por Turing, em 1943), ou a qualquer máquina do início do século XX.

A inteligência artificial fraca centra a sua investigação na criação de inteligência artificial que não é capaz de verdadeiramente raciocinar e resolver problemas. Uma tal máquina com esta característica de inteligência agiria como se fosse inteligente, mas não tem autoconsciência ou noção de si. O teste clássico para aferição da inteligência em máquinas é o Teste de Turing.

Há diversos campos dentro da IA fraca, e um deles é a Linguagem Natural, que trata de estudar e tentar reproduzir os processos de desenvolvimento que resultaram no funcionamento normal da língua. Muitos destes campos utilizam softwares específicos e linguagens de programação criadas para suas finalidades. Um exemplo bastante conhecido é o programa A.L.I.C.E. (Artificial Linguistic Internet Computer Entity, ou Entidade Computadorizada de Linguagem Artificial para Internet), um software que simula uma conversa humana. Programado em Java e desenvolvido com regras heurísticas para os caracteres de conversação, seu desenvolvimento resultou na AIML (Artificial Intelligence Markup Language), uma linguagem específica para tais programas e seus vários clones, chamados de Alicebots.

Muito do trabalho neste campo tem sido feito com simulações em computador de inteligência baseado num conjunto predefinido de regras. Poucos têm sido os progressos na IA forte. Mas dependendo da definição de IA utilizada, pode-se dizer que avanços consideráveis na IA fraca já foram alcançados.

Criticas filosóficas e a argumentação de uma IA forte

Muitos filósofos, sobretudo John Searle e Hubert Dreyfus, inseriram no debate questões de ordem filosófica e epistemológica, questionando qualquer possibilidade efetiva da IA forte. Seriam falsos, assim, os próprios pressupostos da construção de uma inteligência ou consciência semelhante à humana em uma máquina.

Searle é bastante conhecido por seu contra-argumento sobre o Quarto Chinês (ou Sala Chinesa), que inverte a questão colocada por Minsky a respeito do Teste de Turing. Seu argumento diz que ainda que uma máquina possa parecer falar chinês por meio de recursos de exame comparativo com mostras e tabelas de referência, binárias, isso não implica que tal máquina fale e entenda efetivamente a língua. Ou seja, demonstrar que uma máquina possa passar no Teste de Turing não necessariamente implica em um ser consciente, tal como entendido em seu sentido humano. Dreyfus, em seu livro O que os computadores ainda não conseguem fazer: Uma crítica ao raciocínio artificial, argumenta que a consciência não pode ser adquirida por sistemas baseados em regras ou lógica; tampouco por sistemas que não façam parte de um corpo físico. No entanto, este último autor deixa aberta a possibilidade de um sistema robótico baseado em Redes Neuronais, ou em mecanismos semelhantes, alcançar a inteligência artificial.

Mas já não seria a referida IA forte, mas sim um correlato bem mais próximo do que se entende por IA fraca. Os revezes que a acepção primeira de Inteligência Artificial vem levando nos últimos tempos contribuíram para a imediata relativização de todo seu legado. O papel de Marvin Minsky, figura proeminente do MIT e autor de Sociedade da Mente, fora central para a acepção de uma IA linear que imitaria com perfeição a mente humana. Atualmente, no entanto, as vertentes que trabalham com os pressupostos da emergência e com elementos da IA fraca parecem ter ganhado proeminência do campo.

As críticas sobre a impossibilidade de criar uma inteligência em um composto artificial podem ser encontradas em Jean-François Lyotard (O Pós-humano) e Lucien Sfez (Crítica da Comunicação); uma contextualização didática do debate encontra-se em Sherry Turkle (O segundo Eu: os computadores e o espírito humano). Pode-se resumir o argumento central no fato de que a própria concepção de inteligência é humana é, nesse sentido, animal e biológica. A possibilidade de transportá-la para uma base plástica, artificial, encontra um limite claro e preciso: se uma inteligência puder ser gerada a partir destes elementos, deverá ser necessariamente diferente da humana, na medida em que o seu resultado provém da emergência de elementos totalmente diferentes dos encontrados nos humanos. A inteligência, tal como a entendemos, é essencialmente o fruto do cruzamento da uma base biológica com um complexo simbólico e cultural, impossível de ser reproduzido artificialmente.

Outros filósofos sustentam visões diferentes. Ainda que não vejam problemas com a IA fraca, entendem que há elementos suficientes para se crer na IA forte também. Daniel C. Dennett argumenta em Consciência Explicada que se não há uma centelha mágica ou alma nos seres humanos, então o Homem é apenas uma outra máquina. Dennett questiona por que razão o Homem-máquina deve ter uma posição privilegiada sobre todas as outras possíveis máquinas quando provido de inteligência.

Alguns autores sustentam que se a IA fraca é possível, então também o é a forte. O argumento da IA fraca, de uma inteligência imitada mas não real, desvelaria assim uma suposta validação da IA forte. Isso se daria porque, tal como entende Simon Blackburn em seu livro Think, dentre outros, não existe a possibilidade de checar se uma inteligência é verdadeira ou não. Estes autores argumentam que toda inteligência apenas parece inteligência, sem necessariamente o ser. Parte-se do princípio que é impossível separar o que é inteligência de fato do que é apenas simulação: apenas acredita-se ser.

Estes autores rebatem os argumentos contra a IA forte dizendo que seus críticos reduzem-se a arrogantes que não podem entender a origem da vida sem uma centelha mágica, um Deus ou uma posição superior qualquer. Eles entenderiam, em última instância, máquina como algo essencialmente incapaz e sequer conseguem supô-la como capaz de inteligência. Nos termos de Minsky, a crítica contra a IA forte erra ao supor que toda inteligência derive de um sujeito - tal como indicado por Searle - e assim desconsidera a possibilidade de uma maquinaria complexa que pudesse pensar.

O debate sobre a IA reflete, em última instância, a própria dificuldade da ciência contemporânea em lidar efetivamente com a ausência de um primado superior. Os argumentos pró-IA forte são esclarecedores dessa questão, pois são os próprios cientistas, que durante décadas tentaram e falharam ao criar uma IA forte, que ainda procuram a existência de uma ordem superior. Ainda que a IA forte busque uma ordem dentro da própria conjugação dos elementos internos, trata-se ainda da suposição de que existe na inteligência humana uma qualidade superior que deve ser buscada, emulada e recriada. Reflete, assim, a difícil digestão do legado radical da Teoria da Evolução, onde não existe positividade alguma em ser humano e ser inteligente; trata-se apenas de um complexo de relações que propiciaram um estado particular, produto de um cruzamento temporal entre o extrato biológico e uma complexidade simbólica.

História

Os primeiros anos da IA foram repletos de sucessos – mas de uma forma limitada. Considerando-se os primeiros computadores, as ferramentas de programação da época e o fato de que apenas alguns anos antes os computadores eram vistos como objetos capazes de efetuar operações aritméticas e nada mais, causava surpresa o fato de um computador realizar qualquer atividade remotamente inteligente.

O sucesso inicial prosseguiu com o General Problem Solver ( Solucionador de problemas gerais) ou GPS, desenvolvido por Newell e Simon. Esse programa foi projetado para imitar protocolos humanos de resolução de problemas. Dentro da classe limitada de quebra-cabeças com a qual podia lidar, verificou-se que a ordem em que os seres humanos abordavam os mesmos problemas. Desse modo, o GPS talvez tenha sido o primeiro programa a incorporar a abordagem de “pensar de forma humana”.

Desde o início os fundamentos da inteligência artificial tiveram o suporte de várias disciplinas que contribuíram com idéias, pontos de vista e técnicas para a IA. Os filósofos (desde 400 a.C.) tornaram a IA concebível, considerando as idéias de que a mente é, em alguns aspectos, semelhante a uma máquina, de que ela opera sobre o conhecimento codificado em alguma linguagem interna e que o pensamento pode ser usado para escolher as ações que deverão ser executadas. Por sua vez, os matemáticos forneceram as ferramentas para manipular declarações de certeza lógica, bem como declarações incertas e probabilísticas. Eles também definiram a base para a compreensão da computação e do raciocínio sobre algoritmos.

Os economistas formalizaram o problema de tomar decisões que maximizam o resultado esperado para o tomador de decisões. Os psicólogos adotaram a idéia de que os seres humanos e os animais podem ser considerados máquinas de processamento de informações. Os lingüistas mostraram que o uso da linguagem se ajusta a esse modelo. Os engenheiros de computação fornecem os artefatos que tornam possíveis as aplicações de IA. Os programas de IA tendem a serem extensos e não poderiam funcionar sem os grandes avanços em velocidade e memória que a industria de informática tem proporcionado.

Atualmente, a IA abrange uma enorme variedade de subcampos. Dentre esses subcampos está o estudo de modelos conexionistas ou redes neurais. Uma rede neural pode ser vista como um modelo matemático simplificado do funcionamento do cérebro humano. Este consiste de um número muito grande de unidades elementares de processamento, ou neurônios, que recebem e enviam estímulos elétricos uns aos outros, formando uma rede altamente interconectada.

No processamento, são compostos os estímulos recebidos conforme a intensidade de cada ligação, produzindo um único estímulo de saída. È o arranjo das interconexões entre os neurônios e as respectivas intensidades que define as principais propriedades e o funcionamento de uma RN. O estudo das redes neurais ou o conexionismo se relaciona com a capacidade dos computadores aprenderem e reconhecerem padrões. Podemos destacar também o estudo da biologia molecular na tentativa de construir vida artificial e a área da robótica, ligada à biologia e procurando construir máquinas que alojem vida artificial. Outro subcampo de estudo é a ligação da IA com a Psicologia, na tentativa de representar na máquina os mecanismos de raciocínio e de procura.

Nos últimos anos, houve uma revolução no trabalho em inteligência artificial, tanto no conteúdo quanto na metodologia. Agora, é mais comum usar as teorias existentes como bases, em vez de propor teorias inteiramente novas, fundamentar as informações em teoremas rigorosos ou na evidência experimental rígida, em vez de utilizar como base a intuição e destacar a relevância de aplicações reais em vez de exemplos de brinquedos.

A utilização da IA permite obter não somente ganhos significativos de performance, mas também possibilita o desenvolvimento de aplicações inovadoras, capazes de expandir de forma extraordinária nossos sentidos e habilidades intelectuais. Cada vez mais presente, a inteligência artificial simula o pensamento humano e se alastra por nosso cotidiano.

Desenvolvimento teórico da

tem como me nostrar um resumo que fale sobre investigação para o nosso cotidiano?

Investigação na IA experimental

A inteligência artificial começou como um campo experimental nos anos 50 com pioneiros como Allen Newell e Herbert Simon, que fundaram o primeiro laboratório de inteligência artificial na Universidade de Carnegie-Mellon, e McCarty que juntamente com Marvin Minsky, que fundaram o MIT AI Lab em 1959. Foram eles alguns dos participantes na famosa conferência de verão de 1956 em Darthmouth College.

Historicamente, existem dois grandes estilos de investigação em IA: IA "neats" e IA "scruffies". A IA "neats", limpa, clássica ou simbólica. Envolve a manipulação de símbolos e de conceitos abstractos, e é a metodologia utilizada na maior parte dos sistemas periciais.

Paralelamente a esta abordagem existe a abordagem IA "scruffies", ou "coneccionista", da qual as redes neuronais são o melhor exemplo. Esta abordagem cria sistemas que tentam gerar inteligência pela aprendizagem e adaptação em vez da criação de sistemas desenhados com o objectivo especifico de resolver um problema. Ambas as abordagems apareceram num estágio inicial da história de IA. Nos anos 60s e 70s os coneccionistas foram retirados do primeiro plano da investigação em IA, mas o interesse por esta vertente da IA foi retomada nos anos 80s, quando as limitações da IA "limpa" começaram a ser percebidas.

Pesquisas sobre inteligência artificial foram intensamente custeadas na década de 1980 pela Agência de Projetos de Pesquisas Avançadas sobre Defesa (“Defense Advanced Research Projects Agency”), nos Estados Unidos, e pelo Projeto da Quinta Geração (“Fifth Generation Project”), no Japão. O trabalho subsidiado fracassou no sentido de produzir resultados imediatos, a despeito das promessas grandiosas de alguns praticantes de IA, o que levou proporcionalmente a grandes cortes de verbas de agências governamentais no final dos anos 80, e em conseqüência a um arrefecimento da atividade no setor, fase conhecida como O inverno da IA. No decorrer da década seguinte, muitos pesquisadores de IA mudaram para áreas relacionadas com metas mais modestas, tais como aprendizado de máquinas, robótica e visão computacional, muito embora pesquisas sobre IA pura continuaram em níveis reduzidos.

Aplicações Práticas de Técnicas de IA

Enquanto que o progresso direcionado ao objetivo final de uma inteligência similar à humana tem sido lento, muitas derivações surgiram no processo. Exemplos notáveis incluem as linguagens LISP e Prolog, as quais foram desenvolvidas para pesquisa em IA, mas agora possuem funções não-IA. A cultura Hacker surgiu primeiramente em laboratórios de IA, em particular no MIT AI Lab, lar várias vezes de celebridades tais como McCarthy, Minsky, Seymour Papert (que desenvolveu a linguagem Logo), Terry Winograd (que abandonou IA depois de desenvolver SHRDLU).

Muitos outros sistemas úteis têm sido construídos usando tecnologias que ao menos uma vez eram áreas ativas em pesquisa de IA. Alguns exemplos incluem:

- Planejamento automatizado e escalonamento: a uma centena de milhões de quilômetros da Terra, o programa Remote Agent da NASA se tornou o primeiro programa de planejamento automatizado (autônomo) de bordo a controlar o escalonamento de operações de uma nave espacial. O Remote Agent gerou planos de metas de alto nível especificadas a partir do solo e monitorou a operação da nave espacial à medida que os planos eram executados – efetuando a detecção, o diagnóstico e a recuperação de problemas conforme eles ocorriam.

- Jogos: O Deep Blue da IBM se tornou o primeiro programa de computador a derrotar o campeão mundial em uma partida de xadrez, ao vencer Garry Kasparov por um placar de 3,5 a 2,5 em uma partida de exibição. Kasparov disse que sentiu “uma nova espécie de inteligência” do outro lado do tabuleiro. O valor das ações da IBM teve um aumento de 18 bilhões de dólares.

- Controle autônomo: O sistema de visão de computador ALVINN foi treinado para dirigir um automóvel, mantendo-o na pista. Ele foi colocado na minivan controlada por computador NAVLAB da CMU e foi utilizado para percorrer os Estados Unidos – ao longo de quase 4.600 Km o ALVINN manteve o controle da direção do veículo durante 98% do tempo. Um ser humano assumiu o comando nos outros 2%, principalmente na saída de declives. A NAVLAB tem câmeras e vídeo que transmitem imagens da estrada para ALVINN, que então calcula a melhor forma de guiar, baseado na experiência obtida em sessões de treinamento anteriores.

- Diagnóstico: Programas de diagnóstico medico baseados na analise probabilística foram capazes de executar tarefas no nível de um medico especialista em diversas áreas da medicina. Heckerman (1991) descreve um caso em que um importante especialista em patologia de gânglios linfáticos ridiculariza o diagnostico de um programa em um caso especialmente difícil. Os criadores do programa sugeriram que ele pedisse ao computador uma explicação do diagnostico. A máquina destacou os principais fatores que influenciaram sua decisão e explicou a interação sutil de vários sintomas nesse caso. Mais tarde, o especialista concordou com o programa.

- Planejamento logístico: Durante a crise do Golfo Pérsico em 1991, as forças armadas dos Estados Unidos distribuíram uma ferramenta denominada Dynamic Analysis and Replanning Tool, ou DART, a fim de realizar o planejamento logístico automatizado e a programação de execução do transporte. Isso envolveu até 50.000 veículos, transporte de carga aérea e de pessoal ao mesmo tempo, e teve de levar em conta os pontos de partida, destinos, rotas e resolução de conflitos entre todos os parâmetros. As técnicas de planejamento da IA permitiram a geração em algumas horas de um plano que exigiria semanas com outros métodos. A Defense Advanced Research Project Agency (DARPA) declarou que essa única aplicação compensou com folga os 30 anos de investimentos da DARPA em IA.

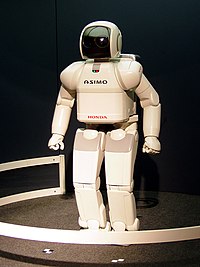

- Robótica: Muitos cirurgiões agora utilizam robôs assistentes em microcirurgias. O HipNav é um sistema emprega técnicas de visão computacional para criar um modelo tridimensional da anatomia interna de um paciente, e depois utiliza controle robótico para orientar a inserção de uma prótese de substituição do quadril.

- Reconhecimento de linguagem e resolução de problemas: O PROVERB é um programa computador que resolve quebra-cabeças de palavras cruzadas melhor que a maioria dos seres humanos, utilizando restrições sobre possíveis preenchimentos de palavras, um grande banco de dados de quebra-cabeças anteriores e uma variedade fonte de informações que incluem dicionários e bancos de dados on-line, como uma lista de filmes e dos atores que participam deles. Por exemplo, ele descobre que a pista “Nice Story” pode ser resolvido por “ETAGE”, porque seu banco de dados inclui o par pista/solução ”Story in France/ETAGE” e porque reconhece que os padrões “Nice X” e “X in France” com freqüência tem mesma solução. O programa não sabe que Nice é uma cidade da França, mas consegue resolver o quebra-cabeça.

- Chinook foi declarado o campeão Homem-Máquina em Damas em 1994.

- Deep Blue, um computador jogador de xadrez, derrotou Garry Kasparov em uma famosa disputa em 1997.

- Lógica incerta, uma técnica para raciocinar dentro de incertezas, tem sido amplamento usada em sistemas de controles industriais.

- Sistemas especialistas vêm sendo usados a uma certa escala industrial.

- Sistemas tradutores, tais como SYSTRAN, têm sido largamente usados (no entanto, os resultados não são ainda comparáveis com tradutores humanos).

- Redes Neurais vêm sendo usadas em uma larga variedade de tarefas, de sistemas de detecção de intrusos a jogos de computadores.

- Sistemas de reconhecimento óptico de caracteres (OCR) podem traduzir letra escrita de forma arbitrária em texto.

- Reconhecimento de escrita a mão é usada em milhões de Assistentes Pessoais Digitais.

- Reconhecimento de voz está disponível comercialmente e é amplamente usado.

- Sistemas de álgebra computacional, tais como Mathematica e Macsyma, são bons exemplos de aplicações de IA na solução de problemas algébricos.

- Sistemas com Visão computacional são usados em muitas aplicações industriais.

- Aplicações utilizando Vida Artificial são utilizados na indústria de entretenimento e no desenvolvimento da Computação Gráfica.

- Sistemas baseados na idéia de agentes artificiais, denominados Sistemas Multiagentes, têm se tornado comuns para a resolução de problemas complexos.

- Chatter bots (robôs de software para conversação), personagens virtuais que conversam em linguagem natural como se fossem humanos de verdade, são cada vez mais comuns na internet.

A visão da Inteligência Artificial substituindo julgamento humano profissional tem surgido muitas vezes na história do campo, em Ficção Científica e, hoje em dia, em algumas áreas especializadas onde "Sistemas Especialistas" são usados para melhorar ou para substituir julgamento profissional em engenharia e medicina, por exemplo.

Consequências hipotéticas da IA

Nenhum observador dos desenvolvimentos da IA antecipam o desenvolvimento de sistema que excederão largamente a inteligência e a complexidade de qualquer coisa atualmente conhecida. Um nome dado a estes sistemas hipotéticos é a de artilectos. Com a introdução de sistemas de inteligência artificial não determinísticos, muitas questões éticas serão levantadas. Muitas destas questões nunca foram abordadas na história da humanidade.

Com o passar do tempo, os debates tenderam a focalizar cada vez menos em “possibilidade” e mais em “desejabilidade”, segundo enfatizado nos debates cosmistas (inglês “Cosmist”, defensor de idéias sobre o cosmo) versus terráqueos (inglês “Terran”), iniciados entre Hugo de Garis e Kevin Warwick. Um cosmista, de acordo com de Garis, na verdade procura construir mais sucessores inteligentes à espécie humana. O surgimento desse debate sugere que questões de desejabilidade podem também ter influenciado alguns dos primeiros pensadores contra a idéia.

Algumas questões que ocasionam perguntas éticas interessantes são:

- Determinação da sensitividade de um sistema que criamos;

- Teste de Turing;

- Cognição;

- Por que afinal sentimos a necessidade de categorizar esses sistemas?

- Pode a IA ser definida em um sentido graduado?

- Liberdades e direitos para esses sistemas;

- Pode IAs ser “mais inteligentes” que os humanos, da mesma forma que somos “mais inteligentes” que outros animais?

- Desenhos de sistemas que são muito mais inteligentes que qualquer humano;

- Decisão do nível de salvaguardas a ser desenhadas nesses sistemas;

- Visão do nível de capacidade de aprendizado que um sistema necessita para replicar o pensamento humano, ou até que ponto satisfatoriamente ele pode realizar tarefas sem essa replicação. (e.g., sistema de perícia);

- A Singularidade;

- Conscientização subjetiva de emoções em relação a carreiras e empregos. Os problemas podem assemelhar-se a problemas detectados no âmbito do livre comércio.

Figuras Famosas

Máquinas que demonstram algum nível de "inteligência"

Existem muitos exemplos de programas que demonstram algum nível de inteligência. Eis alguns exemplos:

- The Start Project - Um sistema baseado em internet que responde a perguntas em inglês.

- Cyc, uma base de conhecimento com colecção vasta dos fatos sobre o mundo real e a habilidade lógica do raciocínio.

- ALICE, um chatterbot.

- Alan, Outro chatterbot.

- ELIZA, Um programa que pretend ser um psicotrapeuta, devolvido por volta de 1970.

- PAM (Plan Applier Mechanism) - Um entendedor de histórias desenvolvido em 1978 por John Wilenksy.

- SAM (Script applier mechanism) - Um entendedor de histórias desenvolvido em 1975..

- SHRDLU - HRDLU era um programa de computador adiantado da compreensão de língua natural, desenvolvido em 1968-1970

- Creatures, um jogo de computador com produção que envolvia criatura codificada de um código genético superior utilizando um sofisticado biochemistry e cérebros de rede neural.

- BBC news story A ultima criação do criador de Creatures . Steve Grand's Lucy.

- EURISKO - uma linguagem para resolver problema que concistam em heuristics, incluindo a descrição do heuristics explicando como usa-lo e modifica-lo. Desenvolvido em 1978 por Douglas Lenat.

- X-Ray Vision for Surgeons - grupo no MIT que investigou visão médica.

- Neural networks-based progams for backgammon and go.

Pesquisas em IA

São muitos milhares de pesquisadores de IA ao redor do mundo em centenas de instituições e de companhias de pesquisa. Entre os muitos que fizeram contribuições significativas estão:

- Marvin Minsky

- Wolfgang Wahlster

- John McCarthy

- Doug Lenat

- Roger Schank

- Alan Turing

- Raj Reddy

- Terry Winograd

Para alguns cientistas da computação, a frase inteligência artificial adquiriu um mau nome devido à discrepância existente entre aquilo que foi conseguido na área, e as outras noções de 'inteligência'. Por esta razão, alguns pesquisadores que trabalham em tópicos relacionaram-se à inteligência artificial dizem que trabalham dentro da ciência cognitiva.

Recursos

Leitura adicional

Não ficção

- Gödel, Escher, Bach : An Eternal Golden Braid (Gödel, Escher, Bach: Uma Trança Eternamente Dourada), por Douglas R. Hofstadter

- Shadows of the Mind (Sombras da Mente) e The Emperor's New Mind (A Nova Mente do Imperador), por Roger Penrose

- Consciousness Explained (A Consciência Explicada), por Dennett.

- The Age of Spiritual Machines (A Era das Máquinas Espirituais), por Ray Kurzweil

- Understanding Understanding: Essays on Cybernetics and Cognition (Entendendo o Entendimento: Ensaios sobre Cibernética e Cognição), por Heinz von Foerster

- In the Image of the Brain: Breaking the Barrier Between Human Mind and Intelligent Machines (Na Imagem do Cérebro: Quebrando a Barreira entre a Mente Humana e as Máquinas Inteligentes), por Jim Jubak

- Today's Computers, Intelligent Machines and Our Future (Os Computadores de Hoje, Máquinas Inteligentes e Nosso Futuro), por Hans Moravec, Stanford University

Ficção

- HAL 9000 em 2001: Uma Odisséia no Espaço

- HARLIE em When H.A.R.L.I.E. was One (Quando H.A.R.L.I.E. era Um), por David Gerrold

- A.I.: Artificial Intelligence (A.I. - Inteligência Artificial)

- A Inteligência Artificial -- principalmente suas implicações filosóficas e seu impacto em ciências humanas -- é um tema central no romance Campus de David Lodge Thinks ... (2001).

- Rosie e outros robôs em Os Jetsons

- Mike em The Moon is a Harsh Mistress de Robert A. Heinlein

- Neuromancer

- Vários romances de Isaac Asimov e as Três Leis da Robótica. São ainda consideradas as melhores no gênero.

- Ghost in the Shell

- The Matrix e suas continuações

- A série The Terminator

- Curto Circuito

- Vários "personagens" de Star Trek, notadamente Data.

- Pensador Profundo em O Guia do Mochileiro das Galáxias de Douglas Adams

- The bomb in Dark Star (1974, by John Carpenter)

- Harry Harrison / Marvin Minsky: The Turing Option (romance)

- The Mind's I editado por Daniel C. Dennett e Douglas Hofstadter

- Personoids, romances e livros de Stanislaw Lem

- Arthur, da série de vídeo game The Journeyman Project

- [WarGames](Jogos de Guerra;1983)

Veja também Lista de robôs de ficção

Organizações relacionadas a IA

- American Association for Artificial Intelligence

- European Coordinating Committee for Artificial Intelligence

- The Association for Computational Linguistics

- Artificial Intelligence Student Union

- German Research Center for Artificial Intelligence, DFKI GmbH

- Association for Uncertainty in Artificial Intelligence

- Singularity Institute for Artificial Intelligence

Fontes

- John McCarthy: Proposal for the Dartmouth Summer Research Project On Artificial Intelligence. [1]

Ver também

Importantes publicações em inteligencia artificial.

Sub-ramos da pesquisa de IA

- Busca combinatória

- Visão computacional

- Sistemas especialistas

- Raciocínio Baseado em Casos

- Programação genética

- Algoritmo genético

- Representação de conhecimento

- Aprendizagem de máquina

- Machine planning

- Rede neural

- Processamento de linguagem natural

- Program synthesis

- Robótica

- Planejamento Automatizado

- Vida artificial

- Artificial being

- Inteligencia Artificial Distribuída

- Swarm Intelligence

- Inteligência artificial e angelologia

A Lógica de programação algumas vezes é considerada como um ramo da inteligencia artificial, mas isto não é mais o caso

Filosofia

Lógica

Ciência

Aplicações

Não categorizados

- Inteligencia coletiva - a idéia a que um número relativamente grande de pessoas que cooperam em um processo podem conduzir à ação de confiança.

- Mente do quantum - a idéia que a coerência em grande escala do quantum é necessária para compreender o cérebro.

- a Singularidade - um tempo no qual o progresso tecnológico acelera além da possiblidade de entendimento do homem de hoje ou o ponto no tempo onde emerge a inteligência mais inteligente que a humana.

- Mindpixel - Um projeto para se coletar afirmações simples verdadeiro/falso e validá-las colaborativamente com o objetivo de usá-las como um corpo de conhecimento humano de senso comum que possa ser utilizado por uma máquina.

- Game programming AI (IA para programação de jogos)

- artificial consciousness (consciência artificial).

Ligações externas

- Programming:AI @ Wikibooks.org

- AI Depot - discussão comunitária, notícias e artigos.

- Loebner Prize website

- AIWiki - um wiki devotado inteiramente à Inteligência Artificial.

- AIAWiki - este é devotado a algoritmos e pesquisa em Inteligência Artificial.

- Mind-1.1

- Mindpixel "The Planet's Largest Artificial Intelligence Effort" (O Maior Esforço em Inteligência Artificial do Planeta).

- OpenMind CommonSense "Teaching computers the stuff we all know" (Ensinando aos computadores as coisas que todos nós sabemos).

- Artificially Intelligent Ouija Board - exemplo criativo de Inteligência Artificial parecida com a humana.

- German Thesis Dissertação filosófica argumentando sobre uma impossibilidade principal de IA. É feita a alegação de que inteligência pressupõe espírito e que não é possível aos humanos criar espírito. Desse modo, um ser inteligente pode no máximo ser imitado tecnicamente.

- Artificial Life - AI Lab Zurich

- Web Resources página da Universidade de Berkeley com links para cerca de 869 outras páginas na Web contendo informação sobre Inteligência Artificial.* generation5 - Página com notícias e artigos sobre IA.

ar:ذكاء اصطناعي bg:Изкуствен интелект bn:কৃত্রিম বুদ্ধিমত্তা bs:Vještačka inteligencija ca:Intel·ligència artificial cs:Umělá inteligence da:Kunstig intelligens de:Künstliche Intelligenz el:Τεχνητή νοημοσύνη en:Artificial intelligence eo:Artefarita inteligenteco es:Inteligencia artificial et:Tehisintellekt eu:Adimen artifiziala fa:هوش مصنوعی fi:Tekoäly fr:Intelligence artificielle gl:Intelixencia artificial he:בינה מלאכותית hi:आर्टिफिशियल इंटेलिजेंस hr:Umjetna inteligencija hu:Mesterséges intelligencia ia:Intelligentia artificial id:Kecerdasan buatan io:Artifical inteligenteso is:Gervigreind it:Intelligenza artificiale ja:人工知能 jbo:rutni menli ko:인공지능 lt:Dirbtinis intelektas mr:कृत्रिम बुद्धिमत्ता nl:Kunstmatige intelligentie nn:Kunstig intelligens no:Kunstig intelligens pl:Sztuczna inteligencja ro:Inteligenţă artificială ru:Искусственный интеллект sh:Umjetna inteligencija simple:Artificial intelligence sk:Umelá inteligencia sl:Umetna inteligenca sr:Вјештачка интелигенција sv:Artificiell intelligens th:ปัญญาประดิษฐ์ tk:Ýasama akyl tr:Yapay zekâ uk:Штучний інтелект vi:Trí tuệ nhân tạo zh:人工智能 zh-min-nan:Jîn-kang tì-hūi

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="O que estudar para o enem 2023">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="O que estudar para o enem 2023"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Qual melhor curso para fazer em 2023">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Qual melhor curso para fazer em 2023"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Enem: Conteúdos E Aulas On-Line São Opção Para Os Estudantes">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Enem: Conteúdos E Aulas On-Line São Opção Para Os Estudantes"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Fazer Uma Carta De Apresentação">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Fazer Uma Carta De Apresentação"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Escrever Uma Boa Redação">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Escrever Uma Boa Redação"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Concurso INSS edital 2022 publicado">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Concurso INSS edital 2022 publicado">