| Linha 83: | Linha 83: | ||

Na fase de geração de código intermediário, ocorre a transformação da árvore sintática em uma representação intermediária do código fonte. Esta linguagem intermediária é mais próxima da linguagem objeto do que o código fonte, mas ainda permite uma manipulação mais fácil do que se código assembly ou código de máquina fosse utilizado.<ref>{{Citar livro|último=Pyster|primeiro=Arthur B.|título=Compiler Design and Construction|subtítulo=Tools and Techniques|língua3=en|edição=|local=Nova Iorque, EUA|editora=Van Nostrand Reinhold Company|ano=1988|páginas=267|página=8|volumes=|volume=|isbn= 0-442-27536-6}}</ref> Um tipo popular de linguagem intermediária é conhecido como [[código de três endereços]].<ref>{{Citar livro|último= Crespo|primeiro=Rui Gustavo|título= Processadores de Linguagens|subtítulo=da Concepção à Implementação|local=Lisboa, Portugal|Editora = IST Press|Ano = 1998|língua3=pt|páginas=435|página=247|isbn= 972-8469-01-2}}</ref> Neste tipo de código uma sentença típica tem a forma <code>X := A op B</code>, onde ''X'', ''A'' e ''B'' são operandos e ''op'' uma operação qualquer. Uma forma prática de representar sentenças de três endereços é através do uso de quádruplas (operador, argumento 1, argumento 2 e, resultado). Este esquema de representação de código intermediário é preferido por diversos compiladores, principalmente aqueles que executam extensivas otimizações de código, uma vez que o código intermediário pode ser rearranjado de uma maneira conveniente com facilidade.<ref name="aho pcd">{{Citar livro|autor=Aho, Alfred V.; Ullman, Jeffrey D.|título=Principles of Compiler Design|subtítulo=|língua3=en|edição=|local=Reading, Massachusetts, EUA|editora=Addison-Wesley|ano=1977|páginas=604|volumes=|volume=|isbn= 0-201-00022-9}}</ref>Outras representações de código intermediário comumente usadas são as triplas, (similares as quádruplas exceto pelo fato de que os resultados não são nomeados explicitamente) as árvores, os [[grafos acíclicos dirigidos]](DAG) e a [[notação polonesa]].<ref>{{Citar livro|último=Muchnick|primeiro=Steven S.|título=Advanced Compiler Design Implementation|subtítulo=|língua3=en|edição=|local=San Francisco, California|editora=Morgan Kaufmann Publishers|ano=1997|páginas=856|página=96|volumes=|volume=|isbn= 1-55860-320-4}}</ref> | Na fase de geração de código intermediário, ocorre a transformação da árvore sintática em uma representação intermediária do código fonte. Esta linguagem intermediária é mais próxima da linguagem objeto do que o código fonte, mas ainda permite uma manipulação mais fácil do que se código assembly ou código de máquina fosse utilizado.<ref>{{Citar livro|último=Pyster|primeiro=Arthur B.|título=Compiler Design and Construction|subtítulo=Tools and Techniques|língua3=en|edição=|local=Nova Iorque, EUA|editora=Van Nostrand Reinhold Company|ano=1988|páginas=267|página=8|volumes=|volume=|isbn= 0-442-27536-6}}</ref> Um tipo popular de linguagem intermediária é conhecido como [[código de três endereços]].<ref>{{Citar livro|último= Crespo|primeiro=Rui Gustavo|título= Processadores de Linguagens|subtítulo=da Concepção à Implementação|local=Lisboa, Portugal|Editora = IST Press|Ano = 1998|língua3=pt|páginas=435|página=247|isbn= 972-8469-01-2}}</ref> Neste tipo de código uma sentença típica tem a forma <code>X := A op B</code>, onde ''X'', ''A'' e ''B'' são operandos e ''op'' uma operação qualquer. Uma forma prática de representar sentenças de três endereços é através do uso de quádruplas (operador, argumento 1, argumento 2 e, resultado). Este esquema de representação de código intermediário é preferido por diversos compiladores, principalmente aqueles que executam extensivas otimizações de código, uma vez que o código intermediário pode ser rearranjado de uma maneira conveniente com facilidade.<ref name="aho pcd">{{Citar livro|autor=Aho, Alfred V.; Ullman, Jeffrey D.|título=Principles of Compiler Design|subtítulo=|língua3=en|edição=|local=Reading, Massachusetts, EUA|editora=Addison-Wesley|ano=1977|páginas=604|volumes=|volume=|isbn= 0-201-00022-9}}</ref>Outras representações de código intermediário comumente usadas são as triplas, (similares as quádruplas exceto pelo fato de que os resultados não são nomeados explicitamente) as árvores, os [[grafos acíclicos dirigidos]](DAG) e a [[notação polonesa]].<ref>{{Citar livro|último=Muchnick|primeiro=Steven S.|título=Advanced Compiler Design Implementation|subtítulo=|língua3=en|edição=|local=San Francisco, California|editora=Morgan Kaufmann Publishers|ano=1997|páginas=856|página=96|volumes=|volume=|isbn= 1-55860-320-4}}</ref> | ||

=== | === Otimização de código === | ||

<!--{{Artigo principal|Optimização de código}}--> | <!--{{Artigo principal|Optimização de código}}--> | ||

A Otimização de código é a estratégia de examinar o código intermediário, produzido durante a fase de geração de código com objetivo de produzir, através de algumas técnicas, um código que execute com bastante eficiência.<ref name="tremblay"/> O nome optimizador deve sempre ser encarado com cuidado, pois não se pode criar um programa que leia um programa P e gere um programa P´ equivalente sendo melhor possível segundo o critério adotado.<ref name="rangel"/> Várias técnicas e várias tarefas se reúnem sob o nome de Optimização. Estas técnicas consistem em detectar padrões dentro do código produzido e substituí-los por códigos mais eficientes.<ref name="aho pcd"/> Entre as técnicas usadas estão a substituição de expressões que podem ser avaliadas durante o tempo de compilação pelos seus valores calculados, eliminação de sub-expressões redundantes, desmembramento de laços, substituição de operações (multiplicação por ''shifts''), entre outras.<ref name="tremblay"/> Uma das técnicas de optimização mais eficazes e independente de máquina é a otimização de laços, pois laços internos são bons candidatos para melhorias. Por exemplo, em caso de computações fixas dentro de laços, é possível mover estas computações para fora dos mesmos reduzindo processamento.<ref>{{Citar livro|último=Kakde|primeiro=O. G.|título=Algorithms for Compiler Design|subtítulo=|língua3=en|edição=|local=Hingham|editora=Charles River media|ano=2003|páginas=334|volumes=|volume=|isbn= 81-7008-100-6}}</ref> | A Otimização de código é a estratégia de examinar o código intermediário, produzido durante a fase de geração de código com objetivo de produzir, através de algumas técnicas, um código que execute com bastante eficiência.<ref name="tremblay"/> O nome optimizador deve sempre ser encarado com cuidado, pois não se pode criar um programa que leia um programa P e gere um programa P´ equivalente sendo melhor possível segundo o critério adotado.<ref name="rangel"/> Várias técnicas e várias tarefas se reúnem sob o nome de Optimização. Estas técnicas consistem em detectar padrões dentro do código produzido e substituí-los por códigos mais eficientes.<ref name="aho pcd"/> Entre as técnicas usadas estão a substituição de expressões que podem ser avaliadas durante o tempo de compilação pelos seus valores calculados, eliminação de sub-expressões redundantes, desmembramento de laços, substituição de operações (multiplicação por ''shifts''), entre outras.<ref name="tremblay"/> Uma das técnicas de optimização mais eficazes e independente de máquina é a otimização de laços, pois laços internos são bons candidatos para melhorias. Por exemplo, em caso de computações fixas dentro de laços, é possível mover estas computações para fora dos mesmos reduzindo processamento.<ref>{{Citar livro|último=Kakde|primeiro=O. G.|título=Algorithms for Compiler Design|subtítulo=|língua3=en|edição=|local=Hingham|editora=Charles River media|ano=2003|páginas=334|volumes=|volume=|isbn= 81-7008-100-6}}</ref> | ||

É importante lembrar que a fase de otimização de código independente das arquiteturas de maquinas faz algumas transformações no código intermediário com o objetivo de produzir um código objeto melhor. Normalmente, melhor significa mais rápido, mas outros objetivos podem ser desejados, como um código menor ou um código objeto que consuma menos energia. Por exemplo, um algoritmo direto gera o código intermediário, usando uma instrução para cada um dos operadores da representação de árvore produzida pelo analisador semântico. | |||

O número de otimizações de código realizadas por diferentes compiladores varia muito. Aqueles que exploram ao máximo as oportunidades de otimizações são chamados de "compiladores otimizadores". Quanto mais otimizações, mais tempo é gasto nessa fase. Mas existem otimizações simples que melhoram significativamente o tempo de execução do programa objeto sem atrasar muito a compilação. | |||

=== Geração de código final === | === Geração de código final === | ||

Edição das 21h03min de 22 de novembro de 2013

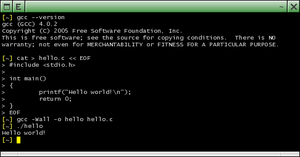

Um compilador é um programa de computador (ou um grupo de programas) que, a partir de um código fonte escrito em uma linguagem compilada, cria um programa semanticamente equivalente, porém escrito em outra linguagem, código objeto.[1] Ele é chamado compilador por razões históricas; nos primeiros anos da programação automática, existiam programas que percorriam bibliotecas de subrotinas e as reunia juntas, ou compilava,[Nota 1] as subrotinas necessárias para executar uma determinada tarefa.[2][3]

O nome "compilador" é usado principalmente para os programas que traduzem o código fonte de uma linguagem de programação de alto nível para uma linguagem de programação de baixo nível (por exemplo, Assembly ou código de máquina). Contudo alguns autores citam exemplos de compiladores que traduzem para linguagens de alto nível como C.[4] Para alguns autores um programa que faz uma tradução entre linguagens de alto nível é normalmente chamado um tradutor, filtro[5] ou conversor de linguagem. Um programa que traduz uma linguagem de programação de baixo nível para uma linguagem de programação de alto nível é um descompilador.[6] Um programa que faz uma tradução entre uma linguagem de montagem e o código de máquina é denominado montador (assembler).[5] Um programa que faz uma tradução entre o código de máquina e uma linguagem de montagem é denominado desmontador (disassembler).[6] Se o programa compilado pode ser executado em um computador cuja CPU ou sistema operacional é diferente daquele em que o compilador é executado, o compilador é conhecido como um compilador cruzado.[7]

História

Os softwares para os primeiros computadores foram escritos principalmente em linguagem assembly por muitos anos. As linguagens de alto nível de programação não foram inventadas até que os benefícios de ser capaz de reutilizar software em diferentes tipos de CPUs passassem a ser significativamente maiores do que o custo de se escrever um compilador. A capacidade de memória muito limitada capacidade dos primeiros computadores também criava muitos problemas técnicos na implementação de um compilador.

No final da década de 1950, as linguagens de programação independentes de máquina foram propostas. Posteriormente, vários compiladores experimentais foram desenvolvidos. O primeiro compilador foi escrito por Grace Hopper,[8] em 1952, para a linguagem de programação A-0.[9] Antes de 1957, foram desenvolvidos esforços e várias contribuições ao desenvolvimento de linguagens de alto nível foram feitas. Entre estes, o desenvolvimento da Short Code (UNIVAC), Speedcoding no IBM 701,[10][11] o Whirlwind, o BACAIC e o PRINT.[12] A equipe de desenvolvimento do FORTRAN liderada por John Backus na IBM é geralmente creditada como tendo introduzido o primeiro compilador completo em 1957 (embora tenha ocorrido simultaneamente o desenvolvimento do algebraic translator de Laning e Zierler[9]). O COBOL é um exemplo de uma linguagem da primeira geração que compilava em múltiplas arquiteturas, em 1960.[13]

Em muitos domínios de aplicação a idéia de usar uma linguagem de alto nível rapidamente ganhou força. Por causa da funcionalidade de expansão apoiada por linguagens de programação recentes e a complexidade crescente de arquiteturas de computadores, os compiladores tornaram-se mais e mais complexos.

Os primeiros compiladores foram escritos em linguagem assembly. O primeiro compilador de auto-hospedagem - capaz de compilar seu próprio código-fonte em uma linguagem de alto nível - foi criado para o Lisp por Tim Hart e Levin Mike no MIT em 1962.[14]

Características

Normalmente, o código fonte é escrito em uma linguagem de programação de alto nível, com grande capacidade de abstração, e o código objeto é escrito em uma linguagem de baixo nível,[15] como uma sequência de instruções a ser executada pelo microprocessador.

O processo de compilação é composto de análise e síntese.[16] A análise tem como objetivo entender o código fonte e representá-lo em uma estrutura intermediária. A síntese constrói o código objecto a partir desta representação intermediária.

A análise pode ser subdividida ainda em análise léxica, análise sintática, análise semântica e geração de código intermediário. É também conhecida como front end.[16] A síntese pode ter mais variações de um compilador a outro, podendo ser composta pelas etapas de optimização de código e geração de código final (ou código de máquina), sendo somente esta última etapa é obrigatória. É também conhecida como back end.[16]

Classicamente, um compilador traduz um programa de uma linguagem textual facilmente entendida por um ser humano para uma linguagem de máquina, específica para um processador e sistema operacional. Atualmente, porém, são comuns compiladores que geram código para uma máquina virtual que é, depois, interpretada por um interpretador.

Em linguagens híbridas, o compilador tem o papel de converter o código fonte em um código chamado de byte code, que é uma linguagem de baixo nível. Um exemplo deste comportamento é o do compilador da linguagem Java que, em vez de gerar código da máquina hospedeira (onde se está executando o compilador), gera código chamado Java Bytecode.[17]

Um compilador é chamado de Just-in-time compiler (JIT) quando seu processo de compilação acontece apenas quando o código é chamado.[18] Um JIT pode fazer otimizações às instruções a medida que as compila.[18]

Muitos compiladores incluem um pré-processador. Um pré-processador é um programa separado, ativado pelo compilador antes do início do processo de tradução.[19] Normalmente é responsável por mudanças no código fonte destinadas de acordo com decisões tomadas em tempo de compilação. Por exemplo, um programa em C permite instruções condicionais para o pré-processador que podem incluir ou não parte do código caso uma assertiva lógica seja verdadeira ou falsa, ou simplesmente um termo esteja definido ou não. Tecnicamente, pré-processadores são muito mais simples que compiladores e são vistos, pelos desenvolvedores, como programas à parte, apesar dessa visão não ser necessariamente compartilhada pelo usuário.

Outra parte separada do compilador que muitos usuários vêem como integrada é o linker, cuja função é unir vários programas já compilados de uma forma independente e unificá-los em um programa executável.[20] Isso inclui colocar o programa final em um formato compatível com as necessidades do sistema operacional para carregá-lo em memória e colocá-lo em execução.

Fases da compilação

Podemos relacionar um compilador a uma caixa-preta que mapeia um programa fonte para um programa objeto semanticamente equivalente. Então se abrirmos essa caixa preta, veremos que existem duas partes desse mapeamento: a análise e a síntese. A análise subdivide o programa fonte em partes constituintes e impõe uma estrutura gramatical sobre elas. Depois, utiliza essa estrutura para criar uma representação intermediária do código fonte. Se a parte da análise detectar que o programa esta mal formado ou sinteticamente errado, ele precisa enviar mensagens esclarecedoras, de modo que o usuário possa corrigi-lo. É na parte de análise que se encontra a coleta de informações sobre o programa fonte e armazena em uma estrutura de dados chamada de Tabela de símbolos. A parte de síntese constrói o programa objeto desejado a partir de representação intermediária e das informações na tabela de símbolos.

Análise léxica

A análise léxica é a primeira das três fases que compõe a análise do texto-fonte

(source). Um analisador léxico, cumpre uma série de tarefas, não somente relacionadas a

análise léxica, de grande importância dentro do compilador. A principal função deste

analisador é a de fragmentar o programa fonte de entrada em trechos elementares completos

e com identidade própria. Estes componentes básicos são chamados tokens.

Token

Padrões de caracteres com um significado específico em um código fonte. Definida por um alfabeto e um conjunto de definições regulares. Usualmente há apenas um pequeno número de tokens para uma linguagem de programação: constantes (inteiros, ponto-flutuante, caracteres, strings, etc.) operadores (aritméticos, relacionais, lógicos) sinais de pontuação palavras reservadas

Analisador léxico

O analisador léxico separa a seqüência de caracteres que representa o programa fonte em entidades ou tokens, símbolos básicos da linguagem. Durante a análise léxica, os tokens são classificados como palavras reservadas, identificadores, símbolos especiais, constantes de tipos básicos (inteiro real, literal, etc.), entre outras categorias.

Análise sintática

A análise sintática, ou análise gramatical é o processo de se determinar se uma cadeia de símbolos léxicos pode ser gerada por uma gramática.[21] O analisador sintático é o cerne do compilador, responsável por verificar se os símbolos contidos no programa fonte formam um programa válido, ou não.[22] No caso de analisadores sintáticos top-down, temos a opção de escrevê-los à mão ou gerá-los de forma automática, mas os analisadores bottom-up só podem ser gerados automaticamente.[23] A maioria dos métodos de análise sintática, cai em uma dessas duas classes denominadas top-down e bottom-up.[24] Entre os métodos top-down os mais importantes são a análise sintática descendente recursiva e a análise sintática preditiva não-recursiva. Entre os métodos de análise sintática bottom-up os mais importantes são a análise sintática de precedência de operadores, análise sintática LR canônico, análise sintática LALR e análise sintática SLR.[21] Existem disponíveis uma série de geradores automáticos de analisadores sintáticos,[25] como por exemplo, o Yacc, o Bison e o JavaCC.

Análise semântica

As análises léxica e sintática não estão preocupadas com o significado ou semântica dos programas que elas processam. O papel do analisador semântico é prover métodos pelos quais as estruturas construídas pelo analisador sintático possam ser avaliadas ou executadas.[26] As gramáticas livres de contexto não são suficientemente poderosas para descrever uma série de construções das linguagens de programação, como por exemplo regras de escopo, regras de visibilidade e consistência de tipos.[27] É papel do analisador semântico assegurar que todas as regras sensíveis ao contexto da linguagem estejam analisadas e verificadas quanto à sua validade. Um exemplo de tarefa própria do analisador semântico é a checagem de tipos de variáveis em expressões.[28] Um dos mecanismos comumente utilizados por implementadores de compiladores é a Gramática de Atributos, que consiste em uma gramática livre de contexto acrescentada de um conjunto finito de atributos e um conjunto finito de predicados sobre estes atributos.[29]

Geração de código intermediário

Na fase de geração de código intermediário, ocorre a transformação da árvore sintática em uma representação intermediária do código fonte. Esta linguagem intermediária é mais próxima da linguagem objeto do que o código fonte, mas ainda permite uma manipulação mais fácil do que se código assembly ou código de máquina fosse utilizado.[30] Um tipo popular de linguagem intermediária é conhecido como código de três endereços.[31] Neste tipo de código uma sentença típica tem a forma X := A op B, onde X, A e B são operandos e op uma operação qualquer. Uma forma prática de representar sentenças de três endereços é através do uso de quádruplas (operador, argumento 1, argumento 2 e, resultado). Este esquema de representação de código intermediário é preferido por diversos compiladores, principalmente aqueles que executam extensivas otimizações de código, uma vez que o código intermediário pode ser rearranjado de uma maneira conveniente com facilidade.[32]Outras representações de código intermediário comumente usadas são as triplas, (similares as quádruplas exceto pelo fato de que os resultados não são nomeados explicitamente) as árvores, os grafos acíclicos dirigidos(DAG) e a notação polonesa.[33]

Otimização de código

A Otimização de código é a estratégia de examinar o código intermediário, produzido durante a fase de geração de código com objetivo de produzir, através de algumas técnicas, um código que execute com bastante eficiência.[28] O nome optimizador deve sempre ser encarado com cuidado, pois não se pode criar um programa que leia um programa P e gere um programa P´ equivalente sendo melhor possível segundo o critério adotado.[34] Várias técnicas e várias tarefas se reúnem sob o nome de Optimização. Estas técnicas consistem em detectar padrões dentro do código produzido e substituí-los por códigos mais eficientes.[32] Entre as técnicas usadas estão a substituição de expressões que podem ser avaliadas durante o tempo de compilação pelos seus valores calculados, eliminação de sub-expressões redundantes, desmembramento de laços, substituição de operações (multiplicação por shifts), entre outras.[28] Uma das técnicas de optimização mais eficazes e independente de máquina é a otimização de laços, pois laços internos são bons candidatos para melhorias. Por exemplo, em caso de computações fixas dentro de laços, é possível mover estas computações para fora dos mesmos reduzindo processamento.[35] É importante lembrar que a fase de otimização de código independente das arquiteturas de maquinas faz algumas transformações no código intermediário com o objetivo de produzir um código objeto melhor. Normalmente, melhor significa mais rápido, mas outros objetivos podem ser desejados, como um código menor ou um código objeto que consuma menos energia. Por exemplo, um algoritmo direto gera o código intermediário, usando uma instrução para cada um dos operadores da representação de árvore produzida pelo analisador semântico. O número de otimizações de código realizadas por diferentes compiladores varia muito. Aqueles que exploram ao máximo as oportunidades de otimizações são chamados de "compiladores otimizadores". Quanto mais otimizações, mais tempo é gasto nessa fase. Mas existem otimizações simples que melhoram significativamente o tempo de execução do programa objeto sem atrasar muito a compilação.

Geração de código final

A fase de geração de código final é a última fase da compilação. A geração de um bom código objeto é difícil devido aos detalhes particulares das máquinas para os quais o código é gerado. Contudo, é uma fase importante, pois uma boa geração de código pode ser, por exemplo, duas vezes mais rápida que um algoritmo de geração de código ineficiente.[32] Nem todas as técnicas de optimização são independentes da arquitetura da máquina-alvo. Optimizações dependentes da máquina necessitam de informações tais como os limites e os recursos especiais da máquina-alvo a fim de produzir um código mais compacto e eficiente. O código produzido pelo compilador deve se aproveitar dos recursos especiais de cada máquina-alvo.[28] Segundo Aho, o código objeto pode ser uma sequência de instruções absolutas de máquina, uma sequência de instruções de máquina relocáveis, um programa em linguagem assembly ou um programa em outra linguagem.[36]

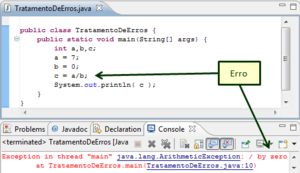

Tratamento de erros

O tratamento de erros está voltado a falhas devido a muitas causas: erros no compilador, erros na elaboração do programa a ser compilado, erros no ambiente (hardware, sistema operacional), dados incorretos, etc. As tarefas relacionadas ao tratamento de erros consitem em detectar cada erro, reportá-lo ao usuário e possivelmente fazer algum reparo para que o processamento possa continuar.[37]

Os erros podem ser classificados em erros léxicos, erros sintáticos, erros não independentes de contexto (semânticos), erros de execução e erros de limite.[38] Os erros léxicos ocorrem quando um token identificado não pertence a gramática da linguagem fonte. Os erros sintáticos ocorrem quando alguma estrutura de frase não está de acordo com a gramática, como por exemplo parênteses sem correspondência. Os erros não independentes de contexto em geral são associados a não declaração de objetos como variáveis e erros de tipos. Os erros de execução ocorrem após a compilação, quando o programa já está sendo executado. Um exemplo típico é o da divisão por zero. Os erros de limite, ocorrem durante a execução e estão relacionados as características da máquina na qual o programa está sendo executado, como por exemplo, estouro de pilha.[38]

Alguns compiladores encerram o processo de tradução logo ao encontrar o primeiro erro do programa-fonte. Esta é uma política de fácil implementação. Compiladores mais sofisticados, porém, detectam o maior número possível de erros visando diminuir o número de compilações.[39]

A recuperação de erros em analisadores sintáticos top-down é mais fácil de implementar do que em analisadores bottom-up.[40] O problema é que diferente de um analisador top-down, este último não sabe quais símbolos são esperados na entrada, somente os que já foram processados. Pode-se usar neste caso técnicas como, por exemplo, a técnica de panic-mode que procura em tabelas sintáticas em busca de símbolos válidos na entrada.[40] Nesta técnica se descartam símbolos da entrada até que um delimitador (como um ponto e vírgula, por exemplo) seja encontrado. O analisador apaga as entradas da pilha até que encontre uma entrada que permita que o processo de análise prossiga em diante.[41]

Ver também

- Ciência da computação

- Compilador Just in Time (JIT)

- Linguagens formais

- Linguagem de programação

- Interpretador

- Linker

Notas

- ↑ Em português, "compilar" significa, por exemplo: reunir obras literárias, documentos, escritos de vários autores, entre outros, compondo uma obra com esse material. Larousse (1992). Dicionário da Língua Portuguesa (em English). [S.l.]: Nova Cultural. ISBN 85-85222-23-9 Parâmetro desconhecido

|Autor=ignorado (|autor=) sugerido (ajuda)

Referências

- ↑ Aho, Alfred V.; Ullman, Jeffrey D. (1977). Principles of Compiler Design (em English). Reading, Massachusetts, EUA: Addison-Wesley. p. 1. 604 páginas. ISBN 0-201-00022-9

- ↑ Parsons, Thomas W. (1992). Introduction to Compiler Construction (em English). Nova Iorque, EUA: Computer Science Press. p. 1. 359 páginas. ISBN 0-7167-8261-8

- ↑ Appel, Andrew W. (1998). Modern Compiler Implementation in Java (em English). Cambridge: Cambridge University Press. p. 3. 548 páginas. ISBN 0-521-58388-8

- ↑ Cooper, Torczon (2003). Engineering a Compiler (em English). San Francisco: Morgan Kaufmann. p. 2. ISBN 1-55860-698-X

- ↑ 5,0 5,1 Neto, João José (1987). Introdução à Compilação (em português). Rio de Janeiro: LTC. 222 páginas. ISBN 978-85-216-0483-9

- ↑ 6,0 6,1 Watt, David A.; Brown, Deryck F. (2000). Programming Language Processors in Java (em English). Harlow, England: Prentice Hall. p. 27. 436 páginas. ISBN 0-130-25786-9

- ↑ Elder, John (1994). Compiler Conctruction. A Recursive Descent Model (em English). 1. Englewood Cliffs, Nova Jersey, EUA: Prentice Hall. p. 7-8. 437 páginas. ISBN 0-13-291139-6

- ↑ Lemone, Karen A. (1992). Fundamentals of Compilers. An Introduction to Computer Language Translation (em English). Boca Raton: CRC. 184 páginas. ISBN 0-8493-7341-7

- ↑ 9,0 9,1 Wexelblat, Richard L.(Editor) (1981). History of Programming Languages. New York: Academic Press. p. 6-15. 758 páginas. ISBN 0-12-745040-8

- ↑ Predefinição:Referência a livro

- ↑ McClelland, William F (1983). «Programming». Annals of The History of Computing (em ingles). 5 (2). Arlington, VA: American Federation of Information Processing Societies. pp. 135–139. ISSN 1058-6180

- ↑ Sammet, Jean E (1969). Programming Languages: History and Fundamentals. Englewood Cliffs, New Jersey: Prentice Hall. p. 5. 785 páginas. ISBN 0-13-729988-5

- ↑ «IP: Os primeiros compiladores COBOL do mundo». interesting-people.org. 12 de Junho de 1997

- ↑ T. Hart and M. Levin. «O novo compilador, AIM-39 - CSAIL Digital Archive - Artificial Intelligence Laboratory Series» (PDF). publications.ai.mit.edu

- ↑ Mak, Ronald (1996). Writing Compilers and Interpreters. An Applied Approach Using C++ (em English). Nova Iorque: John Wiley and Sons. p. 1. 838 páginas. ISBN 0-471-11353-0

- ↑ 16,0 16,1 16,2 Holmes, Jim (1995). Object-Oriented Compiler Construction (em English). Englewood Cliffs, Nova Jersey: Prentice Hall. p. 2-3. 483 páginas. ISBN 0-13-630740-X

- ↑ Sebesta, Robert (2010). Conceitos de Linguagens de Programação (em português) 9ª ed. Porto Alegre: Bookman. p. 49-50. 792 páginas. ISBN 978-85-7780-791-8

- ↑ 18,0 18,1 Engel, Joshua (1999). Programming for the Java Virtual Machine (em English). Reading, Massachusetts: Addison & Wesley. p. 355. 488 páginas. ISBN 0-201-30972-6

- ↑ Louden, Kenneth C. (2004). Compiladores. Princípios e Práticas (em português). São Paulo: Pioneira Thompson Learning. p. 5. 569 páginas. ISBN 85-221-0422-0

- ↑ Levine, John R. (2000). Linkers & Loaders (em English). San Francisco: Morgan Kaufmann Publishers. p. 1-3. 256 páginas. ISBN 1-55860-496-0

- ↑ 21,0 21,1 Aho, Alfred V.; Sethi, Ravi; Ullman, Jeffrey D. (1986). Compilers: Principles, Techniques and Tools (em English). Reading, Massachusetts, EUA: Addison-Wesley. 796 páginas. ISBN 978-0-201-10088-4 Parâmetro desconhecido

|Autor=ignorado (|autor=) sugerido (ajuda); - ↑ Delamaro, Marcio (2004). Como Construir um Compilador Utilizando Ferramentas Java (em português). São Paulo: Novatec. p. 4. 308 páginas. ISBN 85-7522-055-1

- ↑ Grune, Dick; Bal, Henri E.; Jacobs, Ceriel J. H.; Langendoen, Koen G (2001). Projeto Moderno de Compiladores (em português). Rio de Janeiro: Campus. ISBN 978-85-352-0876-4

- ↑ Lewis II, P. M.; Rosenkrantz, D,J.; Stearns, R.E. (1978). Compiler Design Theory (em English). Reading, Massachusetts: Addison-Wesley. p. 227. 647 páginas. ISBN 0-201-14455-7

- ↑ Alblas, Henk; Nymeyer, Albert (1996). Practice and Principles of Compiler Building with C (em English). London: Prentice Hall. p. 30. 427 páginas. ISBN 0-13-349267-2

- ↑ Watson, Des (1989). High-Level Languages and Their Compilers (em English). Wokingham, Reino Unido: Addison-Wesley. 337 páginas. ISBN 0-201-18489-3

- ↑ Wilhelm, Reinhard; Maurer, Dieter (1995). Compiler Design (em English). Harlow, England: Addison-Wesley. 606 páginas. ISBN 0-201-42290-5

- ↑ 28,0 28,1 28,2 28,3 Tremblay, Jean-Paul; Sorenson, Paul G. (1989). The Theory and Practice of Compiler Writing (em English). Nova Iorque: McGraw-Hill. 796 páginas. ISBN 0-07-065161-2

- ↑ Pittman, Thomas; Peters, James (1992). The Art of Compiler Design. Theory and Practice (em English). Englewood Cliffs, Nova Jersey, EUA: Prentice Hall. 419 páginas. ISBN 0-13-048190-4

- ↑ Pyster, Arthur B. (1988). Compiler Design and Construction. Tools and Techniques (em English). Nova Iorque, EUA: Van Nostrand Reinhold Company. p. 8. 267 páginas. ISBN 0-442-27536-6

- ↑ Crespo, Rui Gustavo (1998). Processadores de Linguagens. da Concepção à Implementação (em português). Lisboa, Portugal: IST Press. p. 247. 435 páginas. ISBN 972-8469-01-2

- ↑ 32,0 32,1 32,2 Aho, Alfred V.; Ullman, Jeffrey D. (1977). Principles of Compiler Design (em English). Reading, Massachusetts, EUA: Addison-Wesley. 604 páginas. ISBN 0-201-00022-9

- ↑ Muchnick, Steven S. (1997). Advanced Compiler Design Implementation (em English). San Francisco, California: Morgan Kaufmann Publishers. p. 96. 856 páginas. ISBN 1-55860-320-4

- ↑ Erro de citação: Marca

<ref>inválida; não foi fornecido texto para as refs chamadasrangel - ↑ Kakde, O. G. (2003). Algorithms for Compiler Design (em English). Hingham: Charles River media. 334 páginas. ISBN 81-7008-100-6 Verifique

|isbn=(ajuda) - ↑ Erro em Lua em package.lua na linha 80: module 'Módulo:Citação/CS1/Sugestões' not found.

- ↑ Waite, William M.; Goos, Gerhard (1984). Compiler Construction (em português). Nova Iorque: Springer-Verlag. p. 302. 446 páginas. ISBN 0-387-90821-8

- ↑ 38,0 38,1 Hunter, Robin (1987). Compiladores. Sua Concepção e Programação em Pascal (em português). Lisboa: Presença. p. 259-275. 323 páginas. Depósito legal nº 16057/87

- ↑ Kowaltowski, Tomasz (1983). Implementação de Linguagens de Programação (em português). Rio de Janeiro: Guanabara Dois. p. 170-171. 189 páginas. ISBN 85-7030-009-3

- ↑ 40,0 40,1 Holub, Allen I. (1990). Compiler Design in C (em English). Englewood Cliffs, Nova Jersey: Prentice Hall. p. 201;348. 924 páginas. ISBN 0-13-155045-4

- ↑ Kakde, O. G. (2003). Algorithms for Compiler Design (em English). Hingham: Charles River media. p. 261. 334 páginas. ISBN 81-7008-100-6 Verifique

|isbn=(ajuda)

Bibliografia

- Appel, Andrew W. (1997). Modern Compiler Implementation in C. Basic Techiques (em English). [S.l.]: Cambridge University Press. 398 páginas. ISBN 0-521-58653-4

- Brown, P. J. (1979). Writing Interactive Compilers and Interpreters (em English). Chichester: John Wiley & Sons. 265 páginas. ISBN 0-471-27609-X

- Kaplan, Randy M. (1994). Constructing Language Processors for Little Languages (em English). Nova Iorque: John Wiley & Sons. 452 páginas. ISBN 0-471-59754-6

- Lee, John A. N. (1967). The Anatomy of a Compiler (em English). Nova Iorque: Reinhold Publishing Company. 275 páginas. Library of Congress Catalog Card Number: 67-29207

- Metsker, Steven John (2001). Building Parsers with Java (em English). Boston: Addison-Wesley. 371 páginas. ISBN 0-201-71962-2

- Ricarte, Ivan (2008). Introdução à Compilação (em português). Rio de Janeiro: Campus, Elsevier. 264 páginas. ISBN 978-85-352-3067-3

- Terry, Patrick D. (1986). Programming Language Translation. A Practical Approach (em English). Wokingham: Addison-Wesley. 443 páginas. ISBN 0-201-18040-5

- Wirth, Niklaus (1996). Compiler Construction (em English). [S.l.]: Addison-Wesley. ISBN 0-201-40353-6

Ligações externas

- «Página com material de compiladores» (em português)

- «Compilador Educativo Verto» (em português)

- «Compiladores livres» (em English)

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="O que estudar para o enem 2023">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="O que estudar para o enem 2023"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Qual melhor curso para fazer em 2023">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Qual melhor curso para fazer em 2023"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Enem: Conteúdos E Aulas On-Line São Opção Para Os Estudantes">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Enem: Conteúdos E Aulas On-Line São Opção Para Os Estudantes"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Fazer Uma Carta De Apresentação">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Fazer Uma Carta De Apresentação"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Escrever Uma Boa Redação">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Como Escrever Uma Boa Redação"> " class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Concurso INSS edital 2022 publicado">

" class="attachment-atbs-s-4_3 size-atbs-s-4_3 wp-post-image" alt="Concurso INSS edital 2022 publicado">